“Chúng ta (con người) học được từ rất nhiều dữ liệu thô không cần nhãn gì cả…Thật là tuyệt vời nếu chúng ta có thể có một thuật toán có thể học như vậy – học giống như người – vì đó là một cách học thực tế hơn, chúng ta có nhiều dữ liệu không dán nhãn hơn là những dữ liệu được dán nhãn”. (Lê Viết Quốc)

Daniela Hernandez

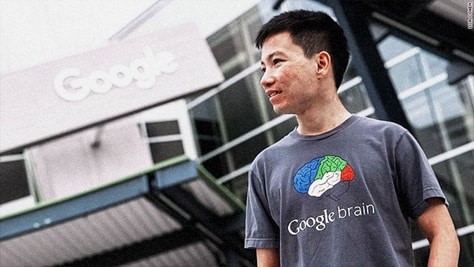

(ảnh: dantri)

Lê Viết Quốc là một trong những thành viên then chốt tại trung tâm nghiên cứu Google Brain và từng được tạp chí công nghệ của MIT (MIT Technology Review) bầu vào 35 Innovators dưới 35 tuổi. Anh Quốc sinh ra tại một làng quê ở miền Trung, lúc nhỏ làng không có điện nên anh hay ra thư viện đọc say sưa sách vở. Khoảng 14 tuổi, anh nhận ra rằng con người cần những cỗ máy thông minh có thể “sáng chế” ra những ý tưởng mới – đây là giấc mơ của anh.

Tốt nghiệp Quốc học Huế năm 2000, Quốc vào đại học Bách Khoa TP.HCM học một học kỳ thì nhận được học bổng phát triển của Úc (AusAID). Quốc ra Hà Nội học tiếng Anh 6 tháng thì sang Úc học khoa học máy tính ở ANU (Australian National University) vào năm 2001 để bắt đầu 4 năm đại học.

Đến cuối năm thứ nhất đầu năm thứ hai đại học, Quốc tham dự chương trình Distinguished Scholar làm công trình nghiên cứu của ANU liên kết với NICTA (National ICT Australia). Từ giữa năm 2004, Quốc làm việc về machine learning (một chuyên ngành của bộ môn trí tuệ nhân tạo) với GS Alex Smola. Giai đoạn này Quốc cũng đã có một số bài báo được đăng trong các kỷ yếu hội thảo và một số tạp chí chuyên ngành.

Đầu năm 2006, Quốc có sang Mỹ cộng tác với một nhóm nghiên cứu ở Microsoft. Năm 2007 Quốc sang Đức làm nghiên cứu với viện Max Planck Biological Cybernetics. Cùng thời gian đó, Quốc nộp hồ sơ làm tiến sĩ ở Stanford và được chấp nhận. Quốc đến Stanford làm việc về machine learning dưới sự hướng dẫn của GS Andrew Ng. Trong thời gian nghiên cứu ở Stanford, từ hai năm nay, Google có lời mời cộng tác nên Quốc đến làm việc ở đây cùng nhóm với GS Andrew Ng. Sau khi bảo vệ thành công luận án tiến sĩ vào đầu năm 2013, Quốc bắt đầu làm việc tại công ty Google chuyên nghiên cứu về trí tuệ nhân tạo và ngôn ngữ. Những sản phẩm như Google Translate (công cụ dịch của Google) và Google Search (công cụ tìm kiếm của Google) đều có các đóng góp của Lê Viết Quốc.

Nếu được cải tiến đáng kể, công nghệ dịch thuật của Google sẽ có tầm quan trọng rất lớn cho tương lai, có ý nghĩa như một cuộc cách mạng. Nó không phải chỉ nhằm phục vụ khách hàng trước mắt, mà thúc đẩy cuộc toàn cầu hóa tri thức nhân loại. Tinh hoa thế giới có thể chốc lát đến tới tận cửa mọi nhà, bằng ngôn ngữ mẹ đẻ. Dịch thuật góp phần cải thiện và phát triển văn hóa, lấp đầy lỗ hổng văn hóa ở những vùng trũng. Bằng sự chan hòa văn hóa, các dân tộc sẽ hiểu biết nhau, gần gũi nhau hơn, có thể sẽ không còn thấy phải giết hại lẫn nhau như thời hoang dã.

Viết Quốc nhìn thế giới như một chuỗi số

Một bức ảnh kỹ thuật số không gì hơn là các con số, anh nói, và nếu bạn tách được các từ nói thành các âm vị (phonemes), bạn cũng có thể biến chúng thành các con số. Sau đó, bạn có thể đưa số liệu đó vào máy, và điều đó có nghĩa là máy sau cùng có thể hiểu được các nội dung của hình ảnh và ý nghĩa của các từ. Facebook có thể nhận ra khuôn mặt của bạn, và Google có thể hành động theo những từ cụ thể bạn nói.

Nhưng Quốc muốn đi xa hơn. Anh muốn tạo ra các công nghệ có thể lấy toàn bộ các câu (sentences), toàn bộ các đoạn văn (paragraphs), và các loại ngôn ngữ tự nhiên khác và biến chúng thành các con số − hoặc các vectơ, các cấu trúc toán mà các nhà khoa học máy tính sử dụng để dịch những điều chúng ta nhìn thấy và nghe thấy thành thông tin mà máy có thể hiểu. Anh ta thậm chí còn thăm dò, khám phá những khả năng máy có thể hiểu những thứ như ý kiến và cảm xúc. Đối với một số công nghệ này, việc thực hiện chúng còn là một chặng đường dài. Nhưng Viết Quốc có nhiều nguồn lực để sử dụng hơn là phần lớn những người khác. Anh làm việc tại trung tâm Google Brain, nơi người khổng lồ Google đi sâu vào ngành “học sâu” (Deep Learning), một hình thức trí tuệ nhân tạo, loại công nghệ xử lý dữ liệu theo những cách thức bắt chước bộ não con người, ít ra về vài phương diện nào đó.

Quốc là một trong những lập trình viên chính của công trình đầu tiên của Google Brain, một hệ thống tự học cách nhận dạng mèo trên các hình ảnh trên YouTube, và kể từ đó, người Việt 32 tuổi này đã giúp đỡ xây dựng các hệ thống Google nhận dạng các từ nói trên điện thoại Android, và tự động đánh dấu (tag) ảnh của bạn trên web, cả hai kỹ thuật đều được hỗ trợ từ công nghệ học-sâu.

“Học sâu” đang thúc đẩy phát triển các công cụ tương tự tại các công ty internet khổng lồ khác, bao gồm Facebook và Microsoft. Khả năng của nó tăng tốc nhận dạng hình ảnh và giọng nói đã được ghi nhận rõ rệt, và công ty khổng lồ Trung Quốc Baidu đã nói công khai về công nghệ này có thể tăng doanh thu như thế nào bằng cách cung cấp một cách tốt hơn cho khách hàng để nhắm mục tiêu quảng cáo. Nhưng Quốc là một trong những người mong muốn đẩy công nghệ vào nhiều lĩnh vực hơn nữa, bao gồm mọi thứ từ sự hiểu biết về ngôn ngữ tự nhiên đến người máy, đến cách công cụ tìm kiếm hiện giờ.

Tại Google, anh đã giúp phát triển một hệ thống chuyển hoá từ vựng thành vectơ toán học. Và theo Google, công trình này sau đó sẽ đưa vào hệ thống được phát triển chủ yếu bởi một nhà nghiên cứu có tên là Tomas Mikolov2. Được gọi là Word2Vec, hệ thống xác định những từ khác nhau trên mạng được liên quan như thế nào, và Google hiện đang sử dụng nó như một phương tiện để tăng cường “đồ thị kiến thức” (knowledge graph) − đó là một tập hợp lớn các kết nối giữa các khái niệm liên quan làm cho cỗ máy tìm kiếm của Google hoạt động rất tốt. Đó là một cách để kiểm tra các sự kiện một cách nhanh chóng hơn − và ở quy mô lớn hơn. Và còn nhiều thứ hơn nữa đang trên đường thực hiện.

“Thực là bực bội”

Khi Quốc lần đầu tiên bắt đầu nghiên cứu AI, vào những năm 1990, nó “thực sự làm phiền” anh. Anh không thích các hệ thống máy-học dựa quá nhiều vào đầu vào (input) từ các kỹ sư con người. Máy có thể học − ít nhất đến một mức độ nhất định − nhưng chúng cần đến hàng lố hướng dẫn để làm được như vậy. Chúng không thể học cách nhận ra những bức ảnh trừ khi những bức ảnh đó được dán nhãn chỉ dẫn từng cái (ví dụ: ảnh này là con mèo, ảnh kia là con cá, …). Để đạt được sự thông minh thực sự, Quốc nói, máy phải tự học, không cần nhãn hiệu chỉ dẫn, giống như con người.

“Chúng ta (con người) học được từ rất nhiều dữ liệu thô không cần nhãn gì cả”, Quốc nói, người đã nghiên cứu về trí thông minh nhân tạo tại Stanford, cùng với Andrew Ng, hiện là giám đốc nghiên cứu của Baidu và là một trong những người sáng lập ra dự án Google Brain. “Thật là tuyệt vời nếu chúng ta có thể có một thuật toán có thể học như vậy – học giống như người – vì đó là một cách học thực tế hơn, chúng ta có nhiều dữ liệu không dán nhãn hơn là những dữ liệu được dán nhãn”. Thật ra, hầu hết những thứ chúng tôi gửi đến những nơi như Facebook và Twitter và Google đều không được gắn nhãn.

Đây là những gì mà học sâu tìm cách đạt được. Sử dụng hàng trăm máy để vận hành “các mạng thần kinh” phức tạp – các kiến trúc (construct) phần mềm có nhiệm vụ bắt chước các mạng nơ-ron trong não – nó cho phép các máy học hỏi. Trong một số trường hợp, việc học đó xảy ra một mình mà không có ai dán nhãn tất cả các dữ liệu.

Máy tìm mèo của Google là một ví dụ quan trọng. Thật không may, ba năm sau, loại học không giám sát này đã không thực sự được ưa chuộng, và hầu hết các hệ thống học-sâu thương mại vẫn dựa vào việc học có giám sát. “Mặc dù chuyện mèo không hữu ích, nhưng trong đầu tôi, một dấu hiệu sáng ra đang thúc đẩy quá trình học sâu để dành nhiều thời gian hơn cho việc học không giám sát như một hứa hẹn cho tương lai”, Ng nói.

Điều đó có thể hữu ích cho việc xử lý ngôn ngữ tự nhiên, hay NLP (Natural Language Processing), một ngành AI nhằm tìm kiếm để hiểu ý nghĩa đằng sau ngôn ngữ − một nhiệm vụ khó khăn hơn việc làm sao để cho máy móc hiểu hình ảnh và các lệnh tiếng nói đơn giản.

Sự thách thức của ngôn ngữ

Một phần của sự thách thức là ngôn ngữ có thể thực sự tinh tế, và chúng ta vẫn không có cách nào tốt để dịch các khái niệm tinh tế. Chẳng hạn, cùng một một từ có thể mang các ý nghĩa khác nhau tùy theo bối cảnh, và hầu hết các hệ thống trí tuệ nhân tạo trên đời vẫn còn gặp khó khăn khi phân biệt giữa chúng. Châm biếm hoặc hài hước thường thất bại hoàn toàn − thậm chí trên các máy tính thông minh nhất.

“Máy hoạt động rất tốt với số. Nhưng chúng không tốt với các biểu tượng (symbols)”, Quốc nói. Và ngôn ngữ là một điều gì có tính biểu tượng cao. Bí quyết là tìm một cách để dịch các biểu tượng thành số. “Làm thế nào để xây dựng một khái niệm thành một cấu trúc toán học để máy móc có thể xử lý nó – điều đó vẫn còn chưa rõ,” anh nói. Nhưng, với những thứ như Word2Vec và các công nghệ xử lý ngôn ngữ tự nhiên khác, Quốc và những người khác đang sẵn sàng để làm một tiến bộ nhất định ở đây. Và đó là những gì chúng ta cần để xây dựng các máy có thể thực sự hiểu được những lượng thông tin khổng lồ được đưa lên mạng với mỗi giây phút trôi qua.

“Sẽ không thể có cách nào để có sự giám sát đầy đủ cho điều đó”, Richard Socher nói, người đã làm nghiên cứu tiến sĩ về học sâu bên cạnh Quốc tại Stanford, và tiếp tục tập trung vào NLP. “Hy vọng là thông qua sự kết hợp của việc học không giám sát và có giám sát, bạn thực sự có thể có được một hệ thống sẽ làm những việc làm kinh ngạc bạn.”

Đoạn văn bằng số

Theo những gì được biết, chuyên gia mạng nơ-ron Yoshua Bengio đã phát triển một thuật toán thông minh đã ánh xạ các từ (words) thành vectơ, và điều này đủ thông minh để gom các từ biểu thị (represent) các khái niệm tương tự thành các nhóm. Ví dụ, các từ thứ Hai hoặc thứ Ba sẽ có các vectơ tương tự vì chúng biểu thị các ngày trong tuần, trong khi một cái gì đó như bánh sandwich sẽ có một sự biểu thị toán học hoàn toàn khác.

Sự tiến hóa tự nhiên sẽ biểu thị những ý tưởng phức tạp hơn − giống như câu hoặc toàn bộ đoạn văn − về mặt toán học. Đầu năm nay, Quốc công bố một bài báo với một người khác của Google, Tomas Mikolov, thực hiện điều đó. Họ mô tả “các vectơ đoạn văn” các cách toán học để biểu thị cho toàn bộ đoạn văn. Google sẽ không nói liệu nó hiện đang có lợi ích từ công việc này hay không − hay lợi thế nào − nhưng bài báo đề cập đến phân tích tình cảm (sentiment analysis) và Lê thừa nhận đây có thể là một trong những ứng dụng của nó. Nói cách khác, nó tìm cách hiểu các quan điểm – thậm chí cả cảm xúc.

Thậm chí gần đây, Quốc đã công bố một bài báo với các nhân viên Google, Ilya Sutskever và Oriol Vinyals, về máy dịch bằng cách sử dụng các mạng thần kinh sâu. Nó được trình bày tại hội nghị Neural Information Processing Systems Foundation ở Montreal vào tuần tới.

Hệ thống này sử dụng một cái gì đó gọi là “mạng thần kinh lặp lại” (recurrent neural networks). Bởi vì chúng phức tạp hơn nên chúng có thể khó đào tạo hơn so với các mạng thần kinh tích chập (convolutional neural networks) được sử dụng rộng rãi hơn. Nhưng lợi thế lớn nhất của chúng là chúng có một bộ nhớ tích hợp, một đặc điểm làm cho chúng đặc biệt hữu ích cho những thứ có tính chuỗi (sequential), như ngôn ngữ. “Rất nhiều người trong chúng ta quan tâm đến việc làm thế nào để ánh xạ một chuỗi dài hơn thành một véctơ. Vectơ đoạn văn là một cách tiếp cận, nhưng điều này có rất nhiều lợi thế – Viết Quốc nói. “Nó có thể nhớ thứ tự các từ trong chuỗi … Nó có thể xử lý các đầu vào có kích thước thay đổi.”

Một bộ não lớn hơn nhiều

Theo bài báo, cách tiếp cận mới tốt hơn các thuật toán máy dịch khác, nhưng đây chỉ là một trong những ứng dụng có thể có của nó. Quốc nói rằng công trình mới này cũng có thể hữu ích cho việc trả lời các câu hỏi trên web, tự động hóa phụ đề và có thể phân tích tình cảm − mặc dù anh cho biết anh vẫn chưa thử.

Để tận dụng đầy đủ các loại thuật toán này, Google sẽ phải xây dựng một số mạng nơ-ron thực sự lớn − lớn hơn nhiều so với những gì nó đã xây dựng cho nhìn và nói. Geoff Hinton, nhân vật trung tâm của phong trào học tập sâu, hiện đang làm việc tại Google, sử dụng một sự so sánh thích hợp. Với não bộ kích thước của một con chim bồ câu, ông nói với WIRED năm ngoái, “bạn có thể có mọi lý do để tin rằng bạn có thể làm một tầm nhìn tốt. Nhưng bạn không muốn trò chuyện với một con chim bồ câu.”

Như một thực tế, một não bộ bồ câu vẫn có thể hoạt động tốt hơn ngay cả những hệ thống thần kinh tiên tiến nhất thế giới, gồm cả Google Brain, về một số nhiệm vụ. Tuy nhiên, Hinton đã gia nhập Google, ông nói, để xây dựng một trong những mạng nơ-ron lớn nhất cho tới nay, một trong số đó có thể “làm lý tính bình thường rất tốt”.

Với sự giúp đỡ của những người như Lê Viết Quốc, điều đó có thể xảy ra.

Daniela Hernandez (12.02.14)

Nguồn: https://www.wired.com/2014/12/googlers-quest-teach-machines-understand-emotions/

Người dịch: Võ Thành Minh Tuệ & Nguyễn Xuân Xanh

Nguồn: https://vukimhanh.com/ve-le-viet-quoc-mot-trong-nhung-chuyen-gia-dau-nganh-ai-tren-the-gioi/